El SEO técnico avanzado es esa parte del posicionamiento en buscadores que no se ve, pero que está y que sostiene todo lo demás. Es lo que tienes que pedir que te explique un SEO cuando trabaja en tu web, pero también es lo que marca la diferencia entre una web que funciona bien, aparece bien posicionada para las palabras clave que nos importan, atrae clientes y vende frente a otra que Google simplemente ignora.

Servidores que responden rápido, estructuras limpias y eliminar fricciones que impiden que los buscadores entiendan el contenido. En definitiva, se trata de hacer que una web funcione bien para lo que ha sido diseñada y generalmente, eso es vender.

Lo veo con frecuencia, cuando un proyecto crece y empiezan los problemas de rastreo, indexación o rendimiento, es cuando el técnico en SEO debe coger los mandos de la nave. No sirvede nada escribir más artículos si Google no puede acceder correctamente a ellos.

En este post verás cómo hacerlo con un enfoque práctico, con los principales puntos a tener en cuenta y llegado el caso, que sepas qué tienes que hacer. Lo que viene a continuación está pensado para aplicar, no para memorizar.

Vamos al lío…

Los fundamentos que no se ven, pero que importan y mucho

El SEO tiene en cuenta varios puntos importantes más allá de si la web es bonita o fea, si tiene nuestros colores o si el logo es horizontal o vertical. Hablo de términos como arquitectura web, sitemap, robots etc.

En mi experiencia, una buena arquitectura web no solo organiza contenidos, que también si no define cómo fluye la autoridad y cómo los robots (Google y otros) interpretan las relaciones entre páginas. Cuando una web no está bien estructurada y crece sin orden, aparecen los agujeros: secciones duplicadas, rutas imposibles de seguir ni con un perro de caza, enlaces rotos o páginas que nadie visita, pero que ahí están y siguen consumiendo presupuesto de rastreo (esto solo se nota en grandes webs, no te preocupes si la tuya es de tamaño pequeño o medio).

Otro punto al que doy mucha importancia es tener un sitemap bien generado —limpio, actualizado y sin errores— y subirlo a Search console. El sitemap es la hoja de ruta, el mapa, que necesitan los buscadores para navegar por tu web.

Otro punto importante es el Robots.txt, actúa como el portero de una discoteca: permite o bloquea el acceso a determinadas zonas. Muchos proyectos no lo usan o no lo tienen pulido y acaban bloqueando sin querer lo que deberían mostrar, o dejando al descubierto lo que debería estar oculto.

Un ejemplo de página a bloquear pueden ser las rutas internas del CMS o panel de administración como por ejemplo en wordpress: midominio.com/wp-amin/ que en robots quedaría como:

Disallow: /wp-admin/

O también, parámetros o filtros que generan contenido duplicado como por ejemplo:

Disallow: /*?filter=

En sitios grandes o muy grandes, otro término del que se habla es de controlar el crawl budget. Pero ojo, se vuelve importante en sitios muy grandes, como periódicos o grandísimos ecommerce. El punto aquí está en que Google no rastrea todo; prioriza lo que considera relevante. Y cuando tu sitio web es muy grande, puede haber páginas por las que no pase y eso genera un problema de visibilidad y ventas.

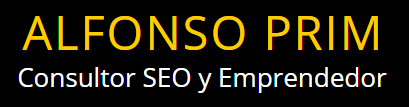

Si el servidor responde lento, hay bucles de redirecciones o miles de páginas inútiles, los bots se marchan antes de tiempo. Una auditoría con herramientas como Screaming Frog, SemRush, Ahrefs o similares, o los informes de Search Console permite detectar esos cuellos de botella y recuperar eficiencia.

Cuando hablamos de SEO técnico avanzado debemos empezar por aquí: en la capacidad de tu web para ser comprendida por Google y otros buscadores, sin obstáculos.

Core Web Vitals: la frontera actual del rendimiento

Hace unos años, cuando empecé con el SEO, allá por 2013, optimizar la velocidad de carga era un consejo más. Hoy es un requisito. Google mide la experiencia del usuario con datos reales, y los Core Web Vitals son su termómetro: si tu web carga lenta, salta o responde tarde, lo sabrá.

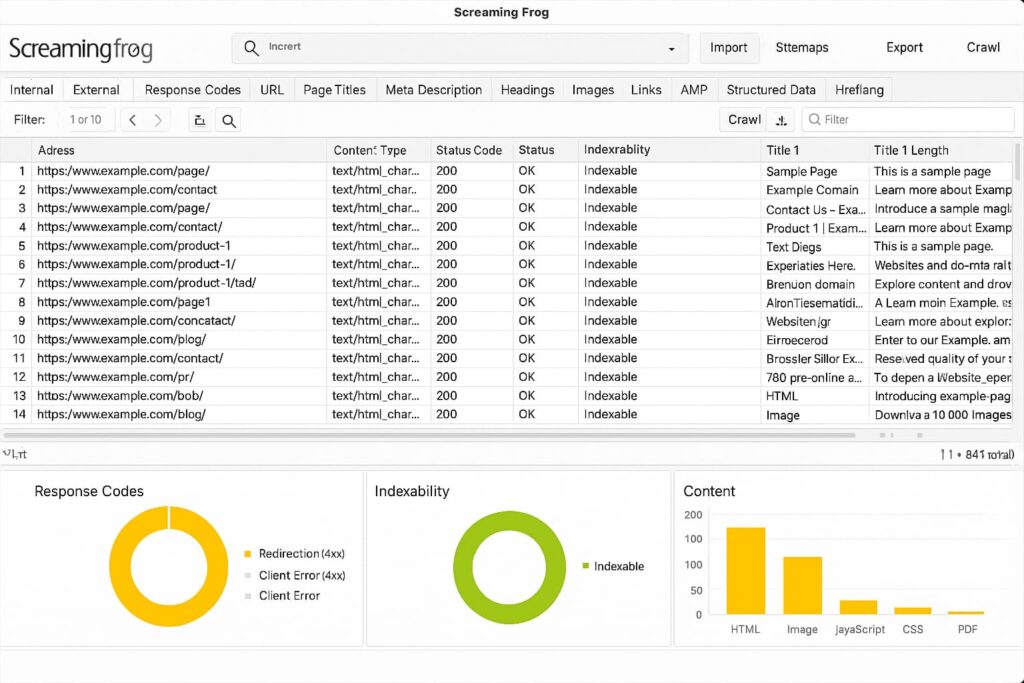

Tres métricas lo resumen todo:

- LCP (Largest Contentful Paint): cuánto tarda en mostrarse el contenido principal de tuweb. A grandes rasgos diría que menos de 1.2s está muy bien, entre 1.2 y 2.5s es aceptable y más de 2.5 s es deficiente y habría que prestarle atención.

- CLS (Cumulative Layout Shift): si los elementos de ti web se mueven mientras cargas la página. Seguro que lo has visto en alguna web que al entrar, empiezas a leer el texto y de pronto ves que todo se desplaza hacia abajo. Eso no es bueno.

- INP (Interaction to Next Paint): la rapidez con la que tu web responde ti web cuando el usuario por ejemplo, hace clic en un botón para cambiar de página o llegar al formulario de contacto.

Y no, no son simples números; reflejan cómo es la experiencia del usuario al navegar por tu web. Un banner mal programado o un script pesado pueden arruinaresa experiencia de usuario.

Las herramientas de PageSpeed Insights, Lighthouse o Chrome UX Report permiten medirlos y priorizar mejoras. Optimizar imágenes, usar compresión moderna (como WebP o Brotli) y minimizar el uso de JavaScript innecesario suele ser suficiente para dar un salto importante.

Cuando una web vuela, los usuarios permanecen más tiempo y Google lo nota. La experiencia de uso tiene repercusión directa en el posicionamiento.

Te pongo en la imagen un ejemplo del resultado del análisis de mi web de Innokabi.com en PageSpeed Insights que puedes probar tú también, para ver qué mejorar y dónde estás bien.

JavaScript y renderizado: el gran olvidado

Por lo que veo en tendencias, cada vez más webs se construyen con frameworks como React, Vue o Angular. Son rápidos, flexibles y modernos… hasta que entra en juego Google. Aunque el buscador es capaz de procesar JavaScript, no lo hace igual que el HTML tradicional. Primero rastrea. Luego intenta renderizar. Y si algo falla por el camino, la página puede quedar sin indexar y lo que es peor, sin que nadie se entere… nadie que no sea un SEO.

El problema no suele ser el código, sino cuándo y cómo se carga el contenido de tu web.

Si el texto o las imágenes principales dependen de scripts que se ejecutan tarde, Google verá una página vacía. Por eso, entender el renderizado es clave.

Una opción segura es el pre-renderizado, es decir, generar versiones estáticas de las páginas que los bots puedan leer sin esperar. Hay algunas herramientas que he probado como Prerender.io, Next.js o Nuxt que te lo ponen fácil.

Algo que me gusta mucho es probar el resultado en Google Search Console y específicamente en la herramienta de “Inspeccionar URL”. Esto me ayuda a comprobar qué ve realmente el robot porque no siempre coincide con lo que tú ves en pantalla. Porque no importa lo que tú ves en pantalla, sino lo que Google consigue leer.

En estos casos el problema es que el buscador no lo vea como debe.

Datos estructurados: el idioma que Google entiende

Este punto me gusta y gusta mucho a los usuarios porque es muy fácil de verlo en los resultados de búsqueda, por ejemplo. Hablo de los datos estructurados, que le dan contexto a Google sobre lo que ve en tu web y le permiten entender qué representa cada elemento: si es un producto, un artículo, una receta o una opinión. Sin ellos, el buscador intuye de qué va cada página dentro de tu web, pero con los datos estructurados, Google comprende tu web. y eso a nivel de resultados es mucho mejor.

El lenguaje común para hacerlo es Schema.org, que es un vocabulario abeirto que traduce la información en un formato que los motores de búsqueda pueden leer fácilmente. Añadirlo no cambia lo que el usuario ve directamente, pero sí cómo Google lo interpreta, como puedes ver en la imagen de más abajo. Esa diferencia puede determinar si tu resultado aparece como un simple enlace o con estrellas, precios y FAQs que multiplican el CTR.

Los tipos más utilizados —Article, Product, FAQ, HowTo o LocalBusiness— cubren la mayoría de proyectos web que puedas pensar. Además, Google ofrece un validador de marcado y Search Console detecta los errores más habituales: etiquetas rotas, propiedades vacías o estructuras incompletas.

Usar datos estructurados ya no es opcional.

En un entorno donde la IA generativa y los resultados enriquecidos ganan peso, el contenido que mejor se entiende es el que más se muestra. Facil ¿no?. Te dejo aquí un ejemplo de un pantallazo sacado hoy de Google con datos estructurados para que veas cómo ayuda tenerlos bien puestos.

SEO para internacionalización y hreflang

Expandir una web a varios idiomas es más que traducir textos como un loro. Si la estructura técnica no acompaña, Google puede confundir versiones, mostrar la versión errónea o duplicar contenidos. El atributo hreflang evita ese caos: indica qué versión mostrar según el idioma o el país del usuario.

Y aquí cuidado porque se puede liar muy gorda si no lo haces bien.

Y ojo que es donde más errores se cometen. Muchos proyectos enlazan mal las versiones/idiomas entre sí o usan códigos de país incorrectos. Un fallo pequeño y Google puede pensar que todas las páginas son la misma y se nos lía todo.

La forma más limpia de organizar una web multilingüe suele ser mediante subcarpetas (tudominio.com/es/, /en/, /fr/). Es una estructura clara, fácil de mantener y que conserva la autoridad del dominio. Los subdominios o dominios separados (ejemplo es.tudominio.com fr.tudominio.com…) solo tienen sentido en estrategias muy grandes, con equipos locales y recursos para gestionarlos por separado.

Conviene revisar el hreflang con frecuencia: cambios de URL, migraciones o nuevas secciones pueden romperlo sin que nadie lo note. Herramientas como Screaming Frog o Sitebulb facilitan la detección de inconsistencias.

La internacionalización bien hecha no solo traduce. Y ojo, si tienes una web en varios idiomas piensa en los recursos que debes tener para atenderlas, atención al cliente, etc.

Indexación avanzada y control de duplicados

En mi epxeriencia, tener muchas páginas indexadas no siempre es buena señal. A veces, la mitad o más sobran. Formularios, filtros, etiquetas o versiones impresas pueden multiplicar URLs que no aportan nada y confundir al buscador. Google gasta tiempo rastreándolas y deja de lado las que sí importan.

El primer paso es identificar esas páginas zombi: contenido repetido, pobre o sin tráfico. Search Console, Screaming Frog o Ahrefs permiten localizarlas fácilmente. Lo recomendable es limpiar lo innecesario con etiquetas noindex, redirecciones o canonicals bien definidos.

El canonical indica qué versión de una página debe considerarse principal. Esto es esencial en tiendas online o webs con parámetros en las URLs como por ejemplo cuando ordenamos productos por antiguedad, colores o tallas. Si está mal implementado, se pierden señales de autoridad o se indexan páginas vacías.

Otro punto crítico son las paginaciones. Google ya no usa rel=“next” y rel=“prev”, así que la mejor estrategia es ofrecer un buen contenido en la primera página y enlazar internamente las siguientes páginas.

Una web optimizada no es la que tiene más URLs, sino la que muestra solo lo que aporta valor. La indexación avanzada consiste en eso: dejarle claro a Google qué merece estar y qué no y eliminar lo que no aporta nada ni al usuario ni a Google.

Y ojo, porque puede haber páginas que sí aporten al usuario y no a Google, pero ahí hay que indicárselo bien al buscador para que lo sepa. Por eso lo de las canonicals, paginaciones, etc. hay que prestarle atención.

Log files y análisis del comportamiento del bot

Los logs del servidor son como la caja negra de tu web. Ahí queda registrado todo lo que entra y sale: usuarios, errores y, sobre todo, el comportamiento de los bots de los buscadores. Analizarlos permite saber qué rastrea Google, con qué frecuencia y qué está ignorando sin que lo sepas.

Una revisión de logs revela patrones invisibles a simple vista. Puedes descubrir, por ejemplo, que Googlebot dedica tiempo a páginas sin valor o que nunca llega a secciones clave. En webs grandes, ese dato marca la diferencia: optimizar el presupuesto de rastreo no es teoría, es estadística.

Herramientas como Screaming Frog Log Analyzer, Botify, Kibana o incluso BigQuery facilitan el trabajo. Basta con cruzar datos de accesos, códigos de respuesta y tiempos de carga para ver qué frena al robot.

Cuando entiendes cómo se mueve Google por tu web, puedes guiarlo hacia donde tú quieras. Ajustar enlaces internos, mejorar respuestas del servidor o eliminar rutas muertas, lo sé por experiencia, cambia por completo la eficiencia del rastreo.

Automatización en el posicionamiento de tu web: el futuro ya está aquí

El SEO técnico genera datos (especialmente en webs medianas y grandes) en cantidades imposibles de revisar a mano. Logs, sitemaps, indexaciones, métricas de Core Web Vitals, cambios en Search Console… todo se actualiza a diario. Intentar controlarlo manualmente es como vaciar el mar con un cubo, no te lo recomiendo.

Por suerte, la automatización se ha convertido en aliada de los equipos SEO y claro, también la IA.

Hoy es posible programar alertas, reportes y tareas que se ejecutan solas mientras tú te centras en lo importante: analizar y decidir.

Con herramientas como Python, Google Sheets o plataformas visuales como Make o Zapier, puedes automatizar auditorías técnicas, detectar errores de indexación o monitorizar cambios en los Core Web Vitals. Incluso se pueden conectar con APIs de Search Console o Analytics para crear paneles en tiempo real.

Algunos equipos van un paso más allá y usan modelos de lenguaje como ChatGPT para resumir grandes volúmenes de logs, identificar patrones o sugerir mejoras. No sustituyen al criterio humano, pero aceleran la parte más pesada y sporífera del trabajo.

La automatización no es una moda; es la forma de mantener el control en proyectos donde el SEO ya no se mide en páginas, sino en miles de URLs. Quien sepa usar la tecnología para ahorrar tiempo tendrá más margen para pensar estrategias.

Checklist de SEO técnico avanzado

En SEO técnico no hay que inventar, ni hay mucho espacio para la improvisación, casi te diría que son matemáticas. Por eso, tener una checklist a mano ayuda a mantener el control de tu web y no dejar nada al azar. Esta lista resume los puntos que cualquier proyecto debería echar un ojo de forma periódica.

Revisión semanal

- Comprobar errores en Search Console (cobertura, indexación y usabilidad).

- Analizar variaciones de velocidad con PageSpeed Insights.

- Detectar redirecciones nuevas o rotas con Screaming Frog.

- Verificar que el sitemap esté actualizado y sin URLs obsoletas.

Revisión mensual

- Auditar logs para comprobar qué secciones rastrea Google y cuáles ignora.

- Revisar el estado de los Core Web Vitals y su evolución.

- Asegurar que los datos estructurados sigan siendo válidos.

- Evaluar páginas con tráfico cero para decidir si se mejoran o se eliminan.

Revisión trimestral

- Revisar estructura y enlazado interno.

- Comprobar consistencia del hreflang en webs multilingües.

- Actualizar redirecciones y canonicals tras cambios de contenido.

- Auditar rendimiento de servidor y tiempo de respuesta.

Descargar una checklist en Excel o Notion y adaptarla a cada proyecto es una forma sencilla de mantener el orden. Espero que te ayude.

Futuro del SEO: IA, SGE y nuevas señales de ranking

El SEO técnico siempre ha ido un paso por delante de las modas. Mientras todos hablan de contenidos o redes, los cambios reales en Google suelen empezar en la trastienda, en lo que no se ve. Y ahora, con la llegada de la IA generativa y el nuevo sistema SGE (Search Generative Experience), el terreno vuelve a moverse.

Google ya no se limita a rastrear e indexar: interpreta, compara y genera y vaya si genera… solo tieens que hacer una búsqueda informativa en Google y ver el primer resultado que ofrece…

Los resultados se transforman en respuestas creadas por inteligencia artificial que combinan varias fuentes. En ese escenario, la estructura técnica cobra aún más peso. Si tu web no se entiende bien, la IA no la usará como fuente.

Las entidades, los datos estructurados y la coherencia semántica son fundamentales. No basta con optimizar palabras clave, hace tiempo que dejó de ser así: hay que construir webs comprensibles, rápidas y que resuelvan la necesidad del usuario o se irá a tu competencia.

También veremos nuevas métricas de experiencia, con los Core Web Vitals evolucionando hacia un análisis más real del comportamiento del usuario. Y la frontera entre SEO técnico y UX será cada vez más difusa: velocidad, interacción y claridad serán parte del mismo lenguaje.

El futuro del SEO técnico no será más complicado, será más inteligente. Y quienes sepan anticiparse —automatizando, estructurando y midiendo con rigor— seguirán apareciendo donde importa: arriba.

Cómo está cambiando el SEO con la inteligencia artificial

La inteligencia artificial está reescribiendo las reglas del juego. Google, Bing y otros motores ya no solo buscan información: la procesan y sintetizan para devolver respuestas completas. En este nuevo contexto, aparecer en la primera posición deja de ser el único objetivo; ahora se trata de ser la fuente que la IA elige para construir su respuesta. Aunque es cierto que las IAs se siguen apoyando en los primeros resultados que ofrecen los buscadores por lo que el SEO está más vivo que nunca.

Los sistemas como Google SGE, Bing Copilot o Perplexity funcionan a partir de una mezcla de indexación tradicional y selección semántica. Analizan el contexto, la autoridad del dominio y la claridad de la información para decidir qué fragmentos usar.

No se limitan a la keyword, sino a la intención y la estructura del conocimiento que aportas.

Para aparecer en esas recomendaciones, el camino pasa por tres ejes que resumo aquí y que vimos con detalle en este otro artículo del blog hablando de SEO para IA:

- Claridad estructural: usa datos estructurados, encabezados coherentes y una jerarquía lógica. La IA prioriza el contenido que puede entender sin esfuerzo.

- Autoridad demostrable: menciona fuentes fiables, enlaza a estudios, y firma los contenidos con nombre y especialización real. La IA premia la credibilidad.

- Contenido explicativo, no redundante: las IAs buscan respuestas precisas y bien organizadas. Un texto que resuelve rápido una pregunta tiene más opciones de ser citado.

La optimización tradicional ya no basta. El SEO del futuro exigirá pensar como un asistente inteligente: anticipar lo que el usuario busca antes de que lo escriba.

En resumen

En mi opinión personal, el SEO técnico avanzado ya no se limita a optimizar para un algoritmo; ahora optimiza para inteligencias que entienden, relacionan y seleccionan contenido. La llegada de la IA y los sistemas generativos ha elevado el listón: las webs que se estructuran bien, comunican con claridad y demuestran autoridad son las que aparecen citadas, no solo posicionadas.

La base, sin embargo, sigue siendo la misma y como decía antes, el SEO está muy vivo por mucho que con cada oleada tecnológica o moda, lo intenten matar: una arquitectura limpia, un rendimiento sólido y una comunicación técnica impecable. Sobre esa base, la IA se convierte en una oportunidad. Los proyectos que sepan traducir su conocimiento en lenguaje estructurado, verificable y accesible, serán los que la inteligencia artificial use como referencia para responder a millones de consultas.

Cuando hablamos de SEO ya no hablamos de un conjunto de trucos, sino de una forma inteligente de pensar la web. Cuando la tecnología cambia, el enfoque importa más que nunca. Y si hay una constante en este mundo, es que Google siempre premia lo que entiende.

👉 Si quieres que veamos cómo mejorar tu SEO sin riesgos,

contacta conmigo, Alfonso Prim.

¿Quieres que te ayude? Haz clic aquí y hablamos

Espero que este post te haya ayudado. Recuerda que tienes más artículos en mi blog